圖/Pexels。

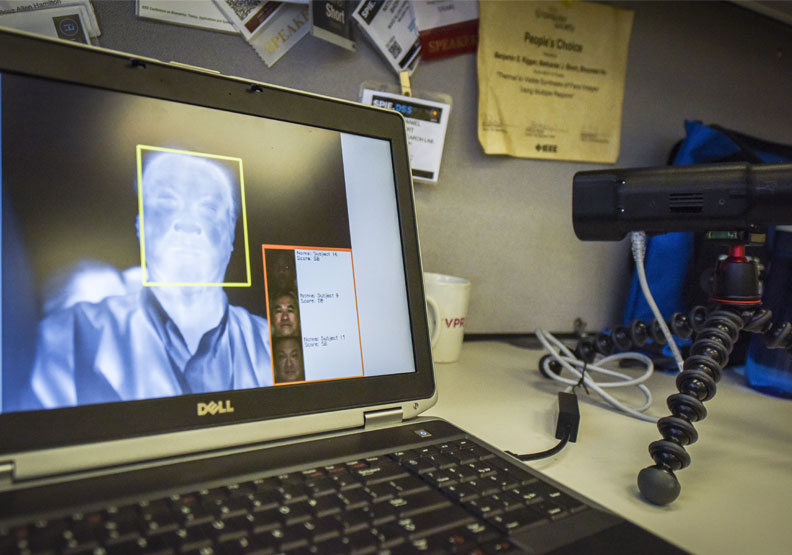

圖/Pexels。 「Deepfake」一詞是由「deep learning(深度學習)」、「fake(偽造)」兩個詞彙混合而成,單就字面上就可以感受到隱含一點負面意涵。這項技術是基於AI運算的人體圖像合成技術,將現有的圖像或影片,透過運算即時模擬表情、肌肉、光影等變化,以最擬真的情境疊加到目標上。

Deepfake技術最常被運用在色情影視上,或是用來偽造名人性愛片、報復性影片等;根據研究,有高達96%的Deepfake製作內容,都是未經同意的色情內容。

台灣同樣也受到Deepfake技術濫用的衝擊。網紅「小玉」便透過該技術,偽造白癡公主、奎丁、蕾拉等網紅的情色影片販售營利,連總統蔡英文、議員黃捷、立委高嘉瑜等都難逃魔掌,不法所得高達千萬。2020年檢調偵破後震驚各界,由於國內法規跟不上科技的演變,最終檢察官諭令小玉以30萬元交保。

為了避免未來再有類似情事發生,行政院10日拍板通過刑法部分條文修正草案以及《兒童及少年性剝削防制條例》、《性侵害犯罪防治法》、《犯罪被害人保護法》等4項修法,規範若製作不實性影像並散布,最重可處5年有期徒刑;若製作且販售營利,最高則可處7年6個月有期徒刑。

法務部強調,這次的修正,針對Deepfake技術的犯罪行為進行規範並且加重刑責,目的就是要提醒民眾應有尊重他人的道德意識,不應未經同意就攝錄或散布性影像,製作造假的深度偽造技術影片更是重中之重,以便維護國人的性隱私與人格權。

除了性影像再製,Deepfake技術也被廣泛運用在商業目的上,有媒體以此技術製作傳播素材,或是保護吹哨者、舉報者身分等。愈來愈多使用面向,讓Deepfake的技術更加成熟,也讓有心人士注意到藉此牟取暴利的「商機」。

近年來,Deepfake技術已不再侷限於惡作劇,除了用在商業上,國際上的詐騙案例更屢見不鮮,以往透過電話、E-mail進行詐騙,稍加注意或許可以防範。但如今,Deepfake技術可以深度模擬外表,騙徒已經高竿到讓受害者連見到面都難辨真假。

此外,Deepfake也愈來愈廣泛的運用在政治宣傳上,操縱、扭曲訊息的真偽。透過Deepfake技術,輕易就可以完成一部國家總統、領導人的影片,對於國家政治的干預尤其嚴重,Facebook、YouTube、Twitter等多個社群平台都頒布禁令,杜絕類似的仿造內容。

事實上,當年因Deepfake影片出事的小玉,更早期就曾運用該技術偽造一段前高雄市長韓國瑜的影片。製作過程僅30分鐘,再加上一位配音員,就可完成幾可亂真的短片,讓外界對於網路訊息的真假更難以分辨。

要如何應對逐漸氾濫的Deepfake技術?在科技快速發展的時代,或許難以永遠杜絕,因此不只是修法與譴責,還需要引起更多人關注,加入發展過濾器等反制技術,才能減少新科技帶來的社會爭議與紛擾。